图神经网络——基于图神经网络的图表征学习方法

图表征学习要求在输入节点属性、边和边的属性(如果有的话)得到一个向量作为图的表征,基于图表征进一步的我们可以做图的预测,而图同构网络(Graph Isomorphism Network, GIN)的图表征网络是当前最经典的图表征学习网络。

1.GNN的邻域聚合(消息传递)

GNN的目标是以图结构数据和节点特征作为输入,以学习到节点(或图)的embedding,用于分类任务。

基于邻域聚合的GNN可以拆分为以下三个模块:

- Aggregate:聚合一阶邻域特征。

- Combine:将邻居聚合的特征 与 当前节点特征合并, 以更新当前节点特征。

- Readout(可选):如果是对graph分类,需要将graph中所有节点特征转变成graph特征。

但是Aggregate的三种方式sum、mean、max的表征能力不够强大。

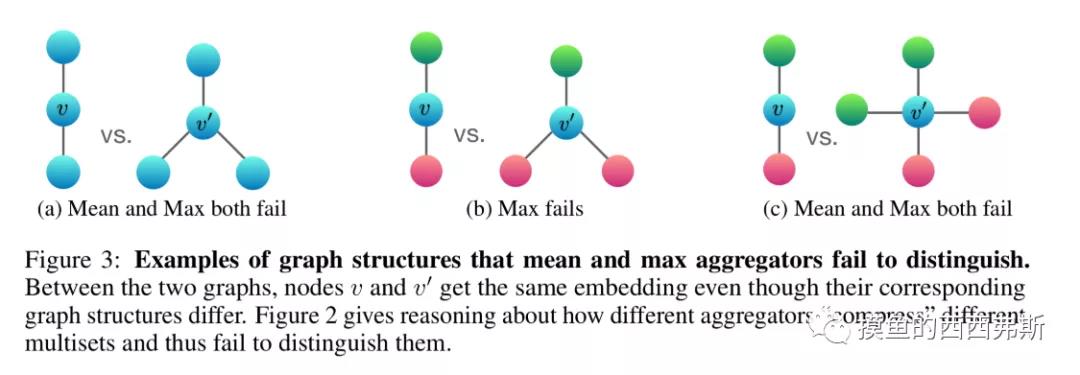

如上图,节点v和v’为中心节点,通过聚合邻居特征生成embedding来分析不同aggregate设置下是否能区分不同的结构。设红绿蓝色节点特征值分别为r,g,b,不考虑combine。

图a中:

mean:左$\frac{1}{2}(b+b)=b$,右$\frac{1}{3}(b+b+b)=b$,无法区分;

max:左$b$,右$b$,无法区分;

sum:左$2b$,右$3b$,可以区分。

图b中:

mean:左$\frac{1}{2}(r+g)$,右$\frac{1}{3}(g+2r)=b$,可以区分;

max:左$max(r,g)$,右$max(r,r,g)$,无法区分;

sum:左$r+g$,右$2r+g$,可以区分。

图c中:

mean:左$\frac{1}{2}(r+g)$,右$\frac{1}{4}(2g+2r)=b$,无法区分;

max:左$max(r,g)$,右$max(r,r,g,g)$,无法区分;

sum:左$r+g$,右$2r+2g$,可以区分。

这说明,sum基本可以学习精确的结构信息、mean偏向学习分布信息,max偏向学习有代表性的元素信息,无法区分某些结构的图,故性能会比sum差一点。

2.Weisfeiler-Lehman Test (WL Test)

图的同构性测试算法(Weisfeiler-Lehman),简称WL Test,是一种用于测试两个图是否同构的算法。

WL Test 的一维形式,类似GNN中的邻接节点聚合。WL Test先迭代地聚合节点及其邻接节点的标签,然后将聚合的标签散列(hash)成新标签,该过程形式化为下方的公示,

$$

L^{h}{u} \leftarrow \operatorname{hash}\left(L^{h-1}{u} + \sum_{v \in \mathcal{N}(U)} L^{h-1}{v}\right)

$$

上式中,$L^{h}{u}$表示节点$u$的第$h$次迭代的标签,第$0$次迭代的标签为节点原始标签。

在迭代过程中,发现两个图之间的节点的标签不同时,就可以确定这两个图是非同构的。需要注意的是节点标签可能的取值只能是有限个数。

WL测试不能保证对所有图都有效,特别是对于具有高度对称性的图,如链式图、完全图、环图和星图,它会判断错误。

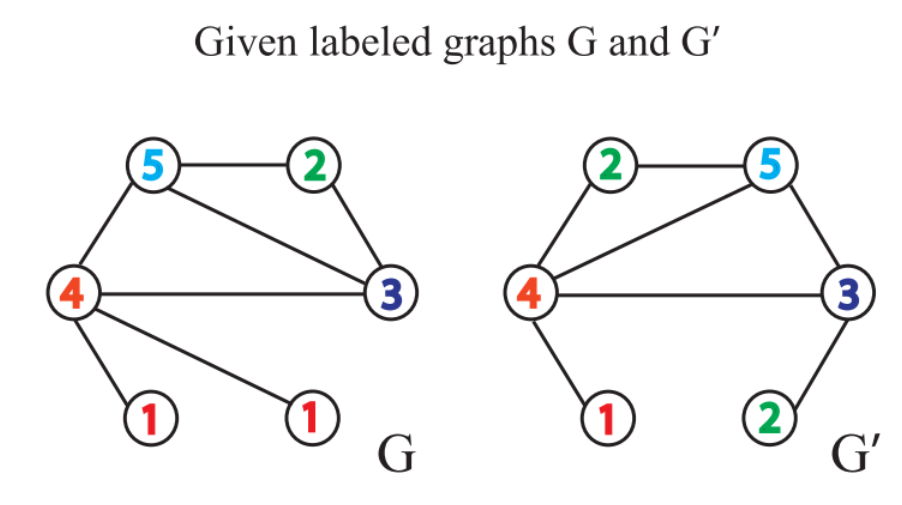

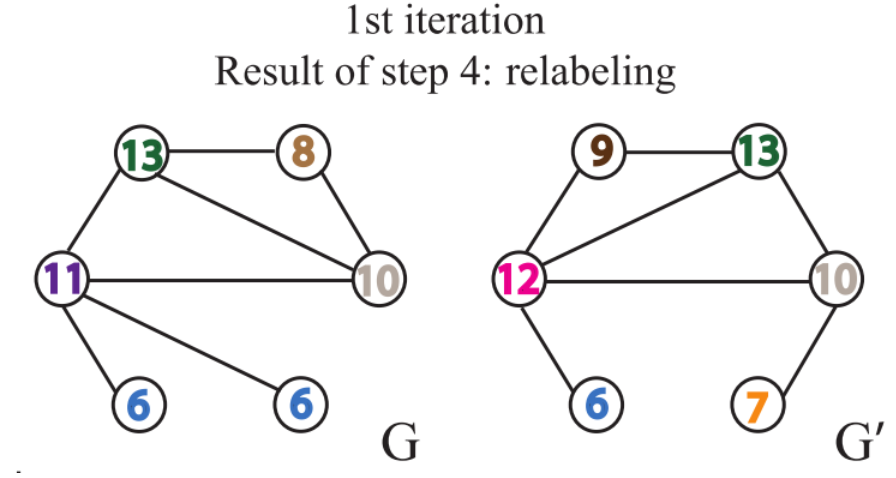

给定两个图$G$和$G^{\prime}$,每个节点拥有标签(实际中,一些图没有节点标签,我们可以以节点的度作为标签)。

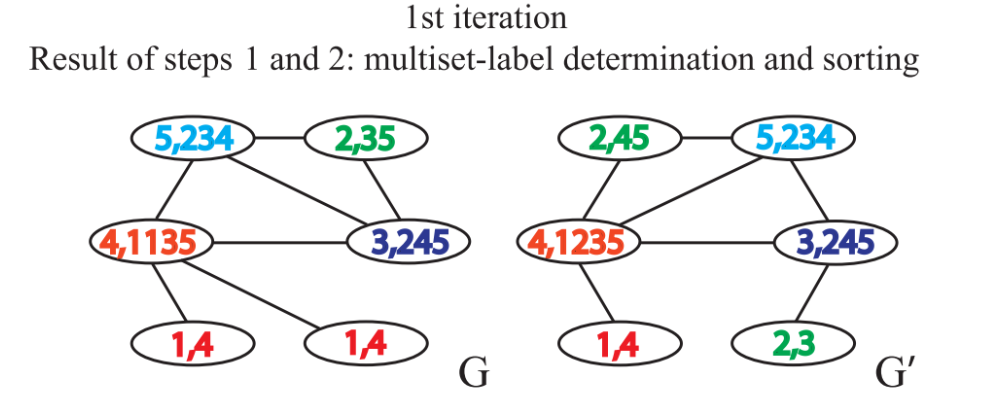

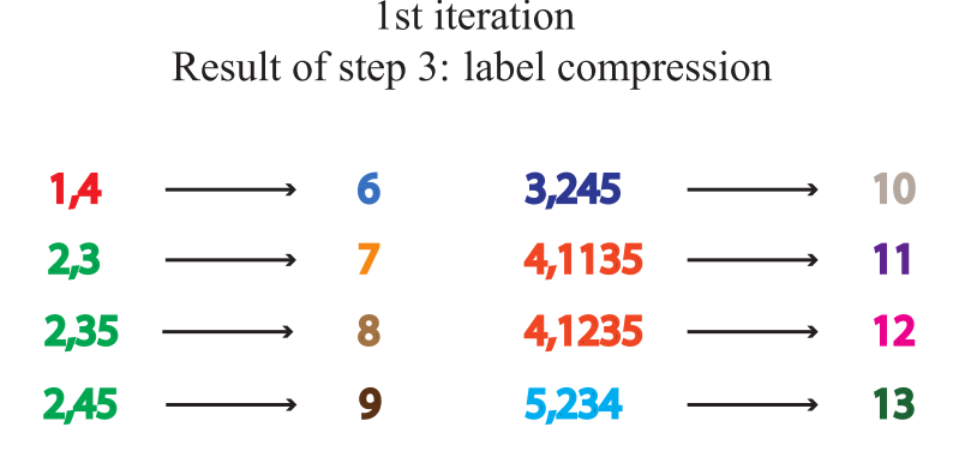

Weisfeiler-Leman Test 算法通过重复执行以下给节点打标签的过程来实现图是否同构的判断:

- 聚合自身与邻接节点的标签得到一串字符串,自身标签与邻接节点的标签中间用

,分隔,邻接节点的标签按升序排序。排序的原因在于要保证单射性,即保证输出的结果不因邻接节点的顺序改变而改变。

- 标签散列,即标签压缩,将较长的字符串映射到一个简短的标签。

- 给节点重新打上标签。

每重复一次以上的过程,就完成一次节点自身标签与邻接节点标签的聚合。

当出现两个图相同节点标签的出现次数不一致时,即可判断两个图不相似。如果上述的步骤重复一定的次数后,没有发现有相同节点标签的出现次数不一致的情况,那么我们无法判断两个图是否同构。

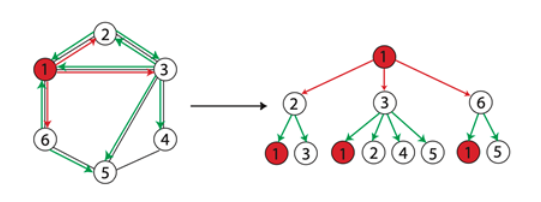

当两个节点的$h$层的标签一样时,表示分别以这两个节点为根节点的WL子树是一致的。WL子树与普通子树不同,WL子树包含重复的节点。下图展示了一棵以1节点为根节点高为2的WL子树。

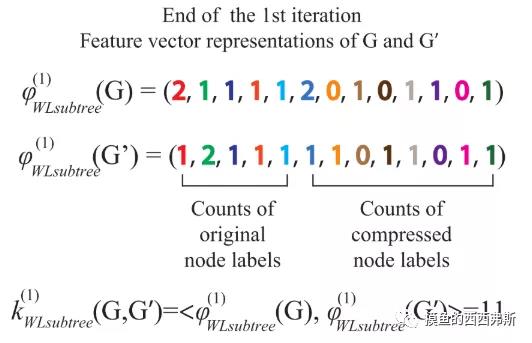

3.图相似性评估

WL Test只能判断两个图的相似性,无法衡量图之间的相似性。要衡量两个图的相似性,需要用WL Subtree Kernel方法。该方法的思想是用WL Test算法得到节点的多层的标签,分别统计图中各类标签出现的次数,存于一个向量,这个向量可以作为图的表征。两个图的表征向量的内积,即可作为这两个图的相似性估计,内积越大表示相似性越高。

4.图同构网络模型的构建

通过GIN学习的节点表征向量可以用于类似于节点分类、边预测这样的任务。而对于图分类任务。READOUT函数:给定独立的节点的表征向量集,生成整个图的表征向量。

GIN的READOUT模块使用concat+sum,对每次迭代得到的所有节点特征求和得到图的特征,然后拼接起来,公式如下:

$$

h_{G} = \text{CONCAT}(\text{READOUT}\left({h_{v}^{(k)}|v\in G}\right)|k=0,1,\cdots, K)

$$

5.基于图同构网络(GIN)的图表征网络的实现

基于图同构网络的图表征学习主要包含以下两个过程:

- 计算得到节点表征;

- 对图上各个节点的表征做图池化(Graph Pooling),或称为图读出(Graph Readout),得到图的表征(Graph Representation)。

基于图同构网络的图表征模块(GINGraphRepr Module),首先采用GINNodeEmbedding模块对图上每一个节点做节点嵌入(Node Embedding),得到节点表征;然后对节点表征做图池化得到图的表征;最后用一层线性变换对图表征转换为对图的预测。代码实现如下:

1 | import torch |

attention:基于Attention对节点表征加权求和,使用模块 torch_geometric.nn.glob.GlobalAttention。

set2set:另一种基于Attention对节点表征加权求和的方法,使用模块 torch_geometric.nn.glob.Set2Set。

6.基于图同构网络的节点嵌入模块(GINNodeEmbedding Module)

此节点嵌入模块基于多层GINConv实现结点嵌入的计算。首先用AtomEncoder对其做嵌入得到第0层节点表征然后我们逐层计算节点表征,从第1层开始到第num_layers层,每一层节点表征的计算都以上一层的节点表征h_list[layer]、边edge_index和边的属性edge_attr为输入。

需要注意的是,GINConv的层数越多,此节点嵌入模块的感受野(receptive field)越大,结点i的表征最远能捕获到结点i的距离为num_layers的邻接节点的信息。

1 | import torch |

7.图同构卷积层(GINConv)

图同构卷积层GINConv的数学定义如下:

$$

\mathbf{x}^{\prime}i = h{\mathbf{\Theta}} \left( (1 + \epsilon) \cdot\mathbf{x}i + \sum{j \in \mathcal{N}(i)} \mathbf{x}_j \right)

$$

构建代码如下:

1 | import torch |